Taula de continguts:

- Autora Lynn Donovan [email protected].

- Public 2023-12-15 23:44.

- Última modificació 2025-01-22 17:20.

Per habilitar el servidor d'historial de Spark:

- Creeu un directori per als registres d'esdeveniments al sistema de fitxers DSEFS: dse hadoop fs -mkdir /spark $ dse hadoop fs -mkdir /spark/events.

- Quan el registre d'esdeveniments està habilitat, el comportament predeterminat és que es desin tots els registres, cosa que fa que l'emmagatzematge creixi amb el temps.

A més d'això, com puc configurar un servidor d'historial d'espurnes?

Per habilitar el servidor d'historial de Spark:

- Creeu un directori per als registres d'esdeveniments al sistema de fitxers DSEFS: dse hadoop fs -mkdir /spark $ dse hadoop fs -mkdir /spark/events.

- Quan el registre d'esdeveniments està habilitat, el comportament predeterminat és que es desin tots els registres, cosa que fa que l'emmagatzematge creixi amb el temps.

De la mateixa manera, com puc trobar l'URL del meu servidor d'historial de spark? Per exemple, per al servidor d'historial , normalment estarien accessibles a servidor - url >:18080/api/v1 i, per a una aplicació en execució, a https://localhost:4040/api/v1. A l'API, es fa referència a una aplicació pel seu ID d'aplicació, [app-id].

De la mateixa manera, què és el servidor Spark History?

El El servidor d'historial de Spark és una eina de seguiment que mostra informació sobre completat Espurna aplicacions. Aquesta informació és extret de les dades que les aplicacions escriuen per defecte en un directori del sistema de fitxers distribuïts de Hadoop (HDFS).

Què és Sparkui?

La interfície d'usuari web de Spark us permet veure una llista d'etapes i tasques del programador, informació ambiental, informació sobre els executors en execució i molt més. Mireu aquesta demostració de 30 minuts per obtenir informació sobre: Components i cicle de vida d'un programa Spark. Com s'executa la vostra aplicació Spark en un clúster Hadoop.

Recomanat:

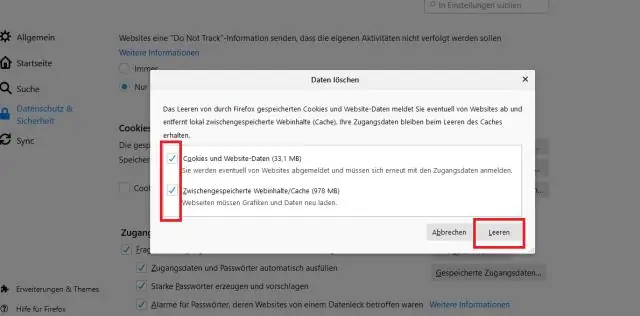

Com puc eliminar l'historial del meu navegador UC del meu ordinador?

Feu clic a la icona d'engranatge Configuració a la barra d'eines de l'UCBrowser. Desplaceu-vos cap avall fins a "Esborra els registres" i premeu-lo. Ara teniu l'opció d'esborrar les galetes, el formulari, l'historial i la memòria cau. Assegureu-vos que "History" estigui marcat i premeu el botó Clear

Com inicio el servidor GlassFish des del símbol d'ordres?

Per iniciar el servidor GlassFish mitjançant la línia d'ordres El número de port del servidor GlassFish: el valor predeterminat és 8080. El número de port del servidor d'administració: el nombre per defecte és 4848. Un nom d'usuari i una contrasenya d'administració: el nom d'usuari per defecte és admin i, per defecte, no hi ha cap contrasenya. requerit

Com puc veure l'historial del meu indicador d'ordres?

Obriu CMD des del menú Inici i escriviu "doskey / History". A mesura que escriviu, totes les ordres que heu escrit darrerament se us mostren a la finestra del CMD. Utilitzeu les fletxes amunt i avall per seleccionar l'ordre. O també podeu copiar i enganxar les ordres de l'historial que ha aparegut a la vostra pantalla, dins de la finestra de CMD

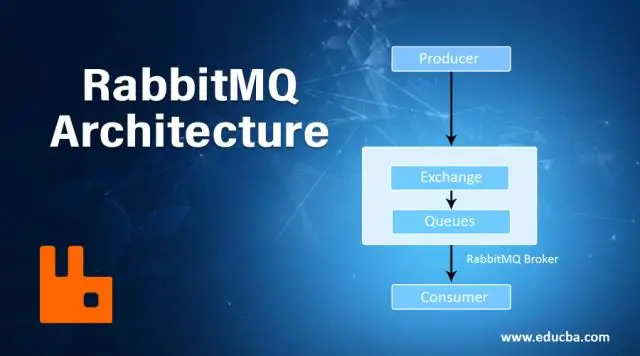

Com inicio el servidor RabbitMQ?

Al menú Inici de Windows, seleccioneu Tots els programes > Servidor RabbitMQ > Inicia el servei per iniciar el servidor RabbitMQ. El servei s'executa en el context de seguretat del compte del sistema sense requerir que l'usuari iniciï sessió a una consola. Utilitzeu el mateix procés per aturar, reinstal·lar i eliminar el servei

Com esborra el meu historial de cerques de Facebook al meu iPhone?

Com esborrar l'historial de cerques de Facebook a l'iPhone Obriu l'aplicació de Facebook a l'iPhone. Toqueu la barra de cerca a la part superior. Toqueu Edita. Toqueu Esborra cerques