Taula de continguts:

- Autora Lynn Donovan [email protected].

- Public 2023-12-15 23:44.

- Última modificació 2025-01-22 17:20.

Pot d'espurna ser correr utilitzant el planificador de clúster autònom integrat al fitxer locals mode. Això vol dir que tots els Espurna processos són correr dins de la mateixa JVM, efectivament, una única instància multiprocés de Espurna.

En aquest sentit, com executo Apache spark localment?

Els passos següents mostren com instal·lar Apache Spark

- Pas 1: verificació de la instal·lació de Java.

- Pas 2: verificació de la instal·lació de Scala.

- Pas 3: descàrrega de Scala.

- Pas 4: instal·lació de Scala.

- Pas 5: descàrrega d'Apache Spark.

- Pas 6: instal·lació de Spark.

- Pas 7: verificació de la instal·lació de Spark.

A més, podem executar Spark sense Hadoop? Segons Espurna documentació, Spark pot funcionar sense Hadoop . Vostè maig executa-ho com a mode autònom sense qualsevol gestor de recursos. Però si vostè voler correr en la configuració de diversos nodes, vostè necessiteu un gestor de recursos com YARN o Mesos i un sistema de fitxers distribuït com HDFS , S3, etc. Sí, l'espurna pot funcionar sense hadoop.

Al costat de dalt, com puc executar spark en mode autònom?

Instal · lar Mode Spark autònom , simplement col·loqueu una versió compilada de Espurna a cada node del clúster. Podeu obtenir versions prefabricades de Espurna amb cada llançament o construïu-lo vosaltres mateixos.

Es pot executar Spark a Windows?

A Espurna aplicació llauna ser a Windows -shell script o això llauna ser un programa personalitzat en Java escrit, Scala, Python o R. Necessites Windows executables instal·lats al vostre sistema per correr aquestes aplicacions.

Recomanat:

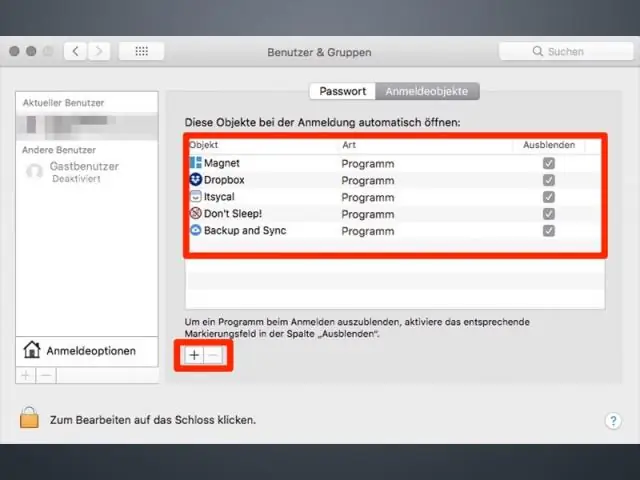

Com puc executar un programa a l'inici al Mac?

Afegiu elements d'inici al vostre Mac a SystemPreferences Inicieu la sessió al vostre Mac amb el compte que feu servir amb l'element d'inici. Seleccioneu Preferències del sistema al menú Apple o feu clic a la icona Preferències del sistema al Dock per obrir la finestra Preferències del sistema. Feu clic a la icona Usuari i grups (o Comptes en versions anteriors d'OS X)

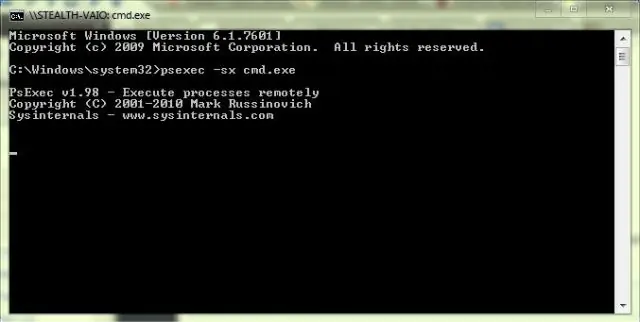

Com puc executar el meu programa C a l'indicador d'ordres?

Com compilar el programa C al símbol del sistema? Executeu l'ordre 'gcc -v' per comprovar si teniu un compilador instal·lat. Creeu un programa c i deseu-lo al vostre sistema. Canvieu el directori de treball a on teniu el vostre Cprogram. Exemple: >cd Desktop. El següent pas és compilar el programa. En el següent pas, podem executar el programa

Puc executar Windows i Mac al mateix ordinador?

Si teniu un Mac basat en Intel, podeu executar OS X i Windows al mateix ordinador. La majoria dels ordinadors PC utilitzen xips basats en Intel, el que significa que ara podeu executar els sistemes operatius Windows i OS X en un ordinador Mac

LastPass pot emmagatzemar les contrasenyes localment?

Les vostres dades de LastPass Vault (p. ex., URL, noms d'usuari i contrasenyes de lloc, notes segures, elements d'emplenament de formularis) s'emmagatzemen localment al vostre ordinador i la ubicació de l'emmagatzematge depèn del sistema operatiu i del navegador web que utilitzeu

Què és l'emmagatzematge connectat localment?

DAS és l'abreviatura d'emmagatzematge connectat directe. L'emmagatzematge adjunt directe (DAS), també anomenat emmagatzematge adjunt directe, és un emmagatzematge digital que s'adjunta directament a un ordinador o un servidor. En altres paraules, DAS no forma part d'una xarxa d'emmagatzematge. L'exemple més conegut de DAS és el disc dur intern d'un ordinador portàtil o d'escriptori